Little bugs and issues with TYPO3 12 and PHP 8.3

Schreib einen Kommentarzazu.berlin– FILM + DIGITAL sagt ... Beiträge

How to get TYPO3 headless with Nuxt3 and the TYPO3 headless extension up and running according to your own needs.

Schreib einen KommentarAutomatic build on save for TypeScript to JavaScript in VSC Visual Studio Code

Schreib einen KommentarJavaScript/TypeScript PHP8 object In JavaScript, the term „object“ is used to refer to the general data type that (a.) represents an instance of a class…

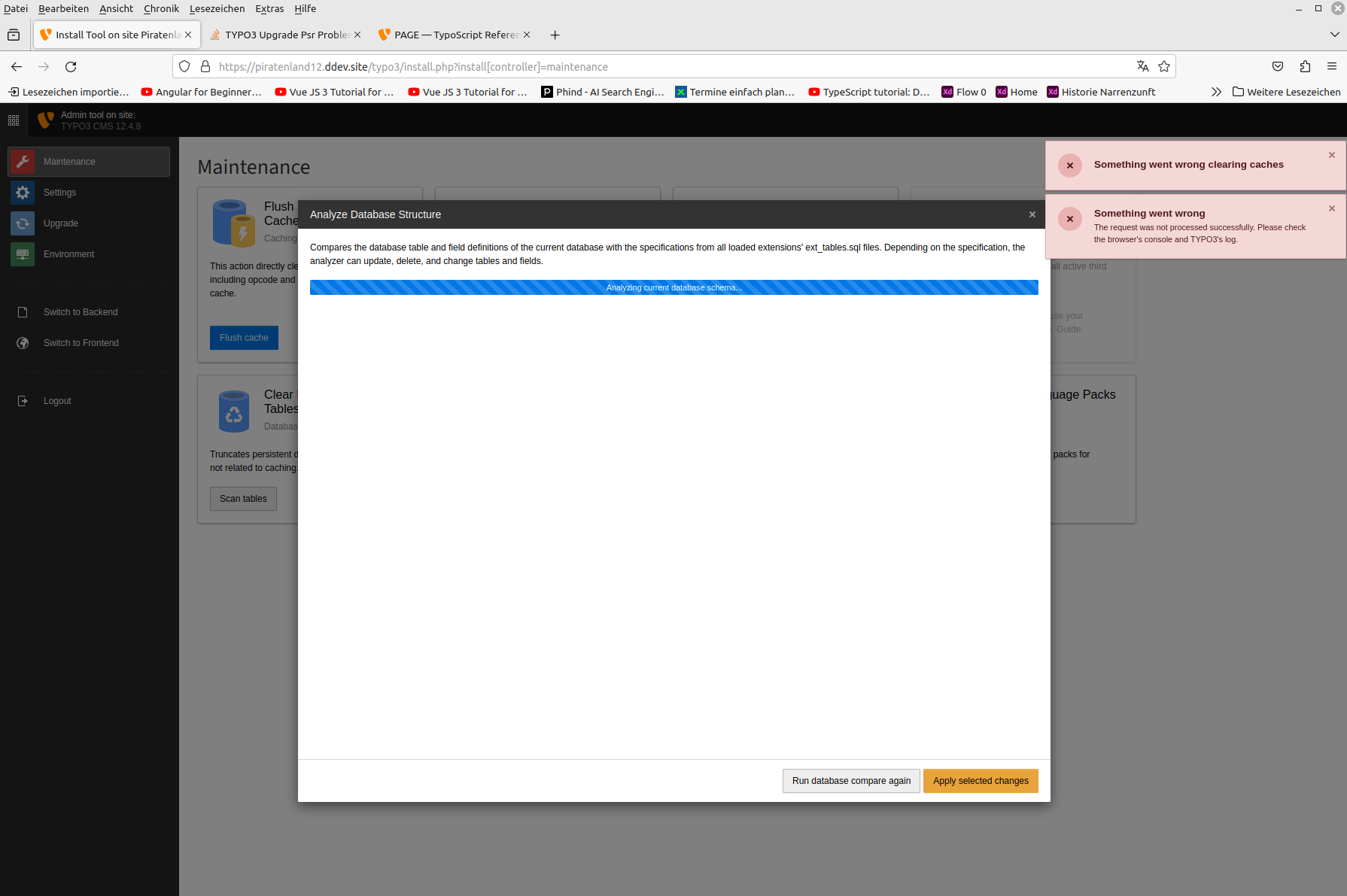

Schreib einen KommentarSolution The solution is quite simple but hard to find. In a sitepackage or another extension usually php-files start with the following code: „TYPO3_Mode“ is…

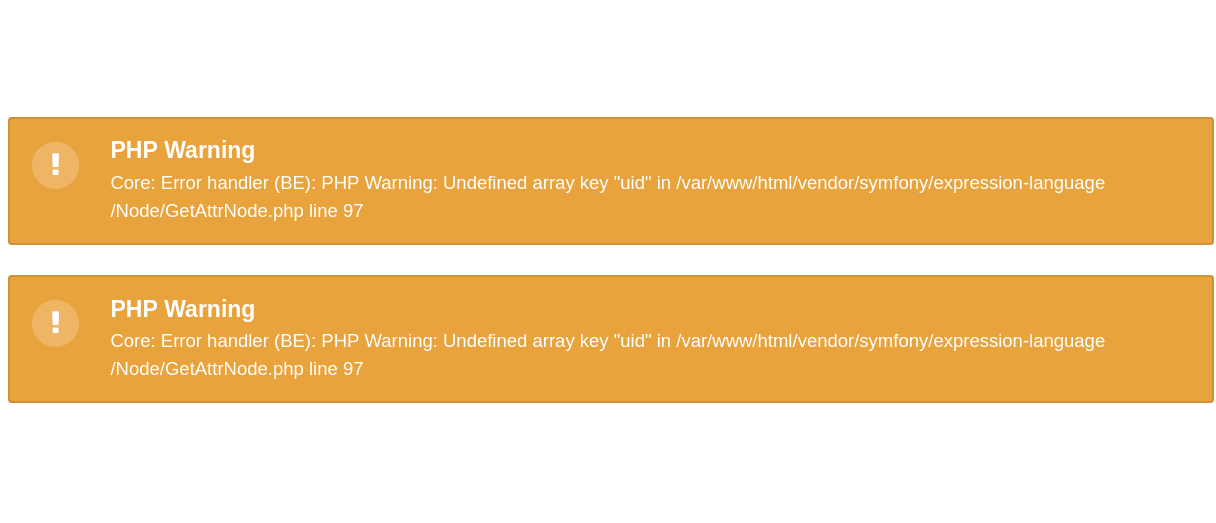

Schreib einen KommentarThis warning (or error) is caused by outdated TYPO3 conditions in TypoScripts. In my case of TYPO3 11.5.30 it only was shown in the backend…

Schreib einen KommentarThe world of website programming is constantly evolving, and with it, so are the values and principles that guide its development. One such value that…

Schreib einen KommentarThe machine Servers are used by the hundreds of thousands in data centres and at some point have fulfilled their duty. These servers can then…

Schreib einen KommentarLoading images with the TYPO3 extension DCE and fluid templates.

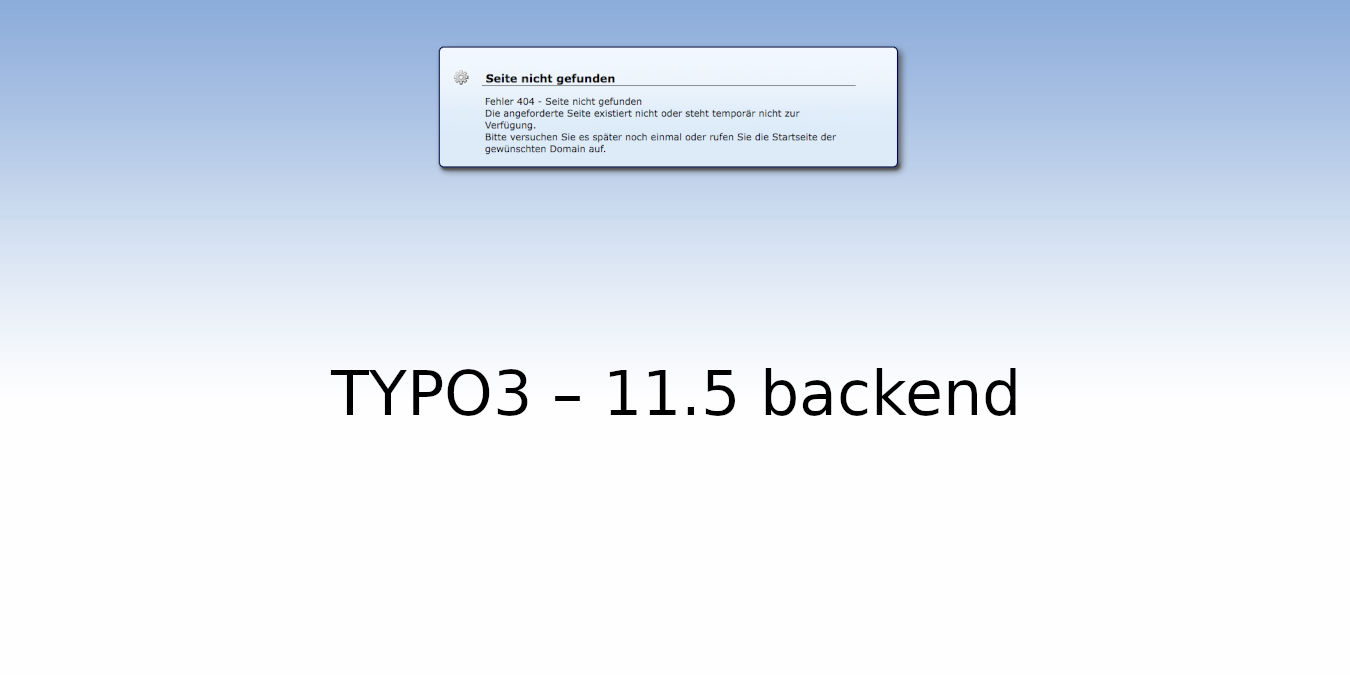

Schreib einen KommentarIn some cases, when updating from TYPO3 version LTS 10.4 to TYPO3 LTS 11.5, the backend is suddenly no longer accessible. Clearing the cache via…

Schreib einen Kommentar